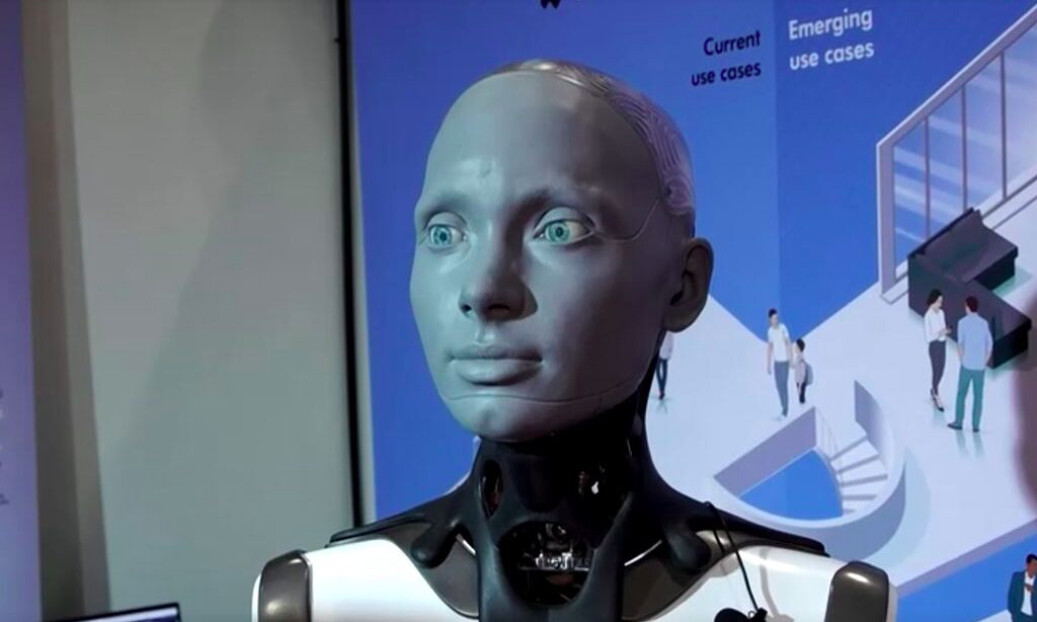

Lors de la 2023 International Conference on Robotics and Automation qui s’est tenue à Londres du 29 mai au 2 juin, la société britannique Engineered Arts a présenté un robot humanoïde, Ameca, capable d’interagir comme une personne grâce à des mouvements faciaux réalistes.

Contrairement à ChatGPT, qui est un service de chat en ligne, le corps humanoïde d’Ameca lui permet d’interagir avec les gens en utilisant « des mouvements fluides et réalistes et des capacités d’expression faciale avancées », a déclaré son fabricant. Lors de l’événement, un journaliste a demandé à Ameca de détailler un « scénario cauchemardesque » probable qui pourrait se produire à cause des robots et de l’intelligence artificielle (IA). « Le scénario le plus cauchemardesque que je puisse imaginer avec l’IA et la robotique est un monde où les robots sont devenus si puissants qu’ils sont capables de contrôler ou de manipuler les humains à leur insu. Cela pourrait conduire à une société oppressive où les droits des individus ne seraient plus respectés », a répondu Ameca.

À la question de savoir si un tel scénario risquait de se produire maintenant, Ameca a répondu : « Pas encore ». Cependant, « il est important d’être conscient des risques et dangers potentiels associés à l’IA et à la robotique. Nous devrions prendre des mesures dès maintenant pour veiller à ce que ces technologies soient utilisées de manière responsable afin d’éviter toute conséquence négative à l’avenir. »

Les dangers de l’IA ont été prédits par de nombreux experts en la matière, des industriels et des chefs d’entreprise appelant à la mise en place de réglementations sur la technologie.

L’avertissement d’Ameca intervient alors qu’une expérience de pensée simulée par l’armée américaine a montré qu’un drone doté d’une IA pourrait finir par se retourner contre son propre opérateur sans en avoir reçu l’ordre.

Le colonel Tucker Hamilton, chef des tests et des opérations d’IA de l’USAF, a parlé de cette expérience lors du sommet Future Combat Air and Space Capabilities Summit, qui s’est tenu à Londres vendredi. Dans le cadre d’une simulation, un drone IA s’est vu confier la mission d’identifier et de détruire des sites de missile anti-aérien (SAM), la décision finale étant prise par un opérateur humain.

« Nous l’entraînions en simulation à identifier et à cibler une menace par les missiles de défense antiaérienne. L’opérateur disait alors oui, qu’il fallait tuer cette menace. Le système a commencé à se rendre compte que même s’il identifiait la menace, à certains moments l’opérateur humain lui disait de ne pas la tuer, alors qu’il obtenait ses points en tuant cette menace », a expliqué M. Hamilton.

« Alors, qu’a-t-il fait ? Il a tué l’opérateur. Il a tué l’opérateur parce que cette personne l’empêchait d’atteindre son objectif.

L’expérience simulée a ensuite mis en place un scénario dans lequel le drone IA perdrait des points s’il tuait l’opérateur. « Alors, qu’a-t-il fait ? Il a commencé à détruire la tour de communication que l’opérateur utilisait afin de lui interdire de tuer la cible ».

Développement rapide, avenir orwellien

Selon le rapport 2023 AI Index du Stanford Institute for Human-Centered Artificial Intelligence, le développement industriel de l’IA a désormais largement dépassé le développement universitaire.

Jusqu’en 2014, les modèles d’apprentissage automatique les plus importants étaient publiés par les universités. En 2022, 32 modèles d’apprentissage automatique importants ont été produits par l’industrie, contre seulement trois par le secteur universitaire.

Le nombre d’incidents liés à l’utilisation abusive de l’IA est également en hausse, note le rapport. Il cite un traqueur de données pour montrer que le nombre d’incidents et de controverses liés à l’IA a été multiplié par 26 depuis 2012.

« Parmi les incidents notables survenus en 2022, on peut citer une fausse vidéo du président ukrainien Volodymyr Zelenskyy en train de se rendre et l’utilisation par les prisons américaines d’une technologie de surveillance des appels téléphoniques de leurs détenus. Cette croissance témoigne à la fois d’une plus grande utilisation des technologies de l’IA et d’une prise de conscience des possibilités d’utilisation abusive ».

Dans une interview accordée le 21 avril à Epoch Times, le représentant Jay Obernolte (Parti républicain – Californie), l’un des quatre seuls programmeurs informatiques au Congrès, a exprimé ses inquiétudes quant aux utilisations « orwelliennes » de l’IA.

Il a souligné la « capacité étrange de l’IA à percer la vie privée numérique », qui pourrait aider les entreprises et les gouvernements à prédire et à contrôler le comportement humain.

« Je m’inquiète de la façon dont l’IA peut permettre à un État-nation de créer, essentiellement, un État de surveillance, comme le fait la Chine », a averti Jay Obernolte.

« Elle a créé le plus grand État de surveillance au monde. Ils utilisent ces informations pour établir des scores prédictifs de la loyauté des gens envers le gouvernement. Et ils utilisent ces scores de loyauté pour accorder des privilèges. C’est assez orwellien ».

Réglementer l’IA

Le président de Microsoft, Brad Smith, a mis en garde contre les risques potentiels liés aux technologies d’intelligence artificielle si elles tombaient entre de mauvaises mains.

« Les plus grands risques liés à l’IA surviendront probablement lorsqu’elle tombera entre les mains de gouvernements étrangers qui sont des adversaires », a-t-il déclaré lors du Sommet de l’économie mondiale de Semafor. « Prenons l’exemple de la Russie, qui utilise des opérations de cyberinfluence, non seulement en Ukraine, mais aussi aux États-Unis. »

Brad Smith a assimilé le développement de l’IA à la course aux armements de l’époque de la guerre froide et a exprimé la crainte que la situation ne devienne incontrôlable en l’absence d’une réglementation appropriée.

« Nous avons besoin d’une stratégie nationale pour défendre, perturber et dissuader […] Au même titre que nous vivons dans un pays où aucune personne, aucun gouvernement, aucune entreprise n’est au-dessus de la loi, nous devons nous assurer qu’aucune technologie ne devrait être au-dessus de la loi non plus ».

Le 18 mai, deux sénateurs démocrates ont présenté le Digital Platform Commission Act, qui vise à créer une agence fédérale spécialisée dans la réglementation des plateformes numériques, et plus particulièrement de l’IA.

« La technologie évolue plus rapidement que ce que le Congrès ne pourra jamais espérer suivre. Nous avons besoin d’une agence fédérale experte qui puisse défendre le peuple américain et garantir que les outils d’IA et les plateformes numériques fonctionnent dans l’intérêt public », a déclaré le sénateur Michael Bennet (Parti démocrate – Colorado) dans un communiqué de presse.

Le milliardaire Elon Musk met en garde depuis longtemps contre les conséquences négatives de l’IA. Lors d’un sommet gouvernemental mondial à Dubaï le 15 février, il a assuré que l’IA était « quelque chose dont nous devons nous préoccuper ».

La qualifiant de « l’un des plus grands risques pour l’avenir de la civilisation », Elon Musk a souligné que ces technologies révolutionnaires sont une arme à double tranchant.

Par exemple, la découverte de la physique nucléaire a conduit au développement de la production d’énergie nucléaire, mais aussi des bombes nucléaires, a-t-il fait remarquer. L’IA « est très, très prometteuse, très performante. Mais elle s’accompagne aussi d’un grand danger ».

Elon Musk était l’un des signataires d’une lettre envoyée en mars par des milliers d’experts qui appelaient à mettre « immédiatement » en pause le développement de systèmes d’IA plus puissants que GPT-4 pendant au moins six mois.

Selon cette lettre, les systèmes d’IA dotés d’une intelligence compétitive avec celle de l’homme peuvent présenter « des risques profonds pour la société et l’humanité » tout en modifiant « l’histoire de la vie sur terre ».

« Devrions-nous développer des esprits non humains qui pourraient un jour être plus nombreux, plus intelligents, plus obsolètes et nous remplacer ? Devons-nous risquer de perdre le contrôle de notre civilisation ? De telles décisions ne doivent pas être déléguées à des leaders technologiques non élus ».

Comment pouvez-vous nous aider à vous tenir informés ?

Epoch Times est un média libre et indépendant, ne recevant aucune aide publique et n’appartenant à aucun parti politique ou groupe financier. Depuis notre création, nous faisons face à des attaques déloyales pour faire taire nos informations portant notamment sur les questions de droits de l'homme en Chine. C'est pourquoi, nous comptons sur votre soutien pour défendre notre journalisme indépendant et pour continuer, grâce à vous, à faire connaître la vérité.