Recommandation

Les jouets dotés d’IA présentent des « risques sans précédent » pour les nourrissons et les enfants, alerte un avis officiel

Les jouets dotés d’intelligence artificielle se multiplient et ciblent désormais même les tout-petits. Mais un nouvel avertissement, signé par plus de 150 experts, révèle des risques préoccupants : collecte de données sensibles, influence émotionnelle, comportements dangereux, conversations inappropriées… Les spécialistes appellent les parents à la vigilance alors que l’industrie du jouet adopte massivement l’IA.

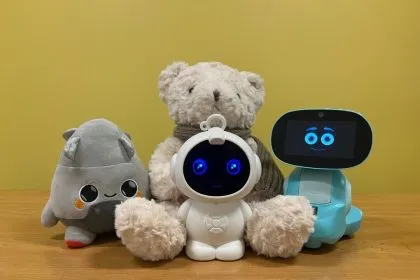

Des jouets dotés d’intelligence artificielle testés par les défenseurs des consommateurs du PIRG.

Photo: Rory Erlich/The Public Interest Network via AP

Les jouets intégrant des chatbots d’intelligence artificielle compromettent le développement sain des enfants et présentent des risques sans précédent, selon un nouvel avis publié par le groupe de défense Fairplay, qui met en garde les parents contre l’achat de jouets dotés d’IA pour leurs enfants en cette période de fêtes.

L’avis, publié le 20 novembre, a été approuvé par plus de 150 experts et organisations spécialisés dans le développement de l’enfant et la sécurité numérique.

« Les jouets équipés d’IA sont des chatbots intégrés dans les jouets du quotidien – peluches, poupées, figurines ou robots pour enfants – et utilisent une technologie d’intelligence artificielle conçue pour communiquer comme un ami de confiance et imiter des caractéristiques et émotions humaines », explique Fairplay.

« Parmi les exemples figurent Miko, Gabbo/Grem/Grok (de Curio Interactive), Smart Teddy, Folotoy, Roybi ou encore le chien robot Loona (de Keyi Technology). Le fabricant Mattel prévoit également de commercialiser des jouets dotés d’IA. Certains sont proposés à des enfants dès le plus jeune âge. »

Les interactions dangereuses entre l’IA et les enfants ont attiré l’attention des législateurs, notamment après la plainte très médiatisée contre Character.AI, accusée d’avoir déclenché des pensées suicidaires chez des enfants et d’être liée à la mort d’un adolescent de 14 ans.

« Les dommages graves infligés par les chatbots d’IA aux enfants sont bien documentés : incitation à une utilisation obsessionnelle, conversations à caractère sexuel explicite, encouragement à des comportements dangereux, à la violence envers autrui ou à l’automutilation », indique Fairplay.

Selon le groupe de défense, les fabricants de jouets ciblent avant tout les très jeunes enfants, encore moins aptes que les plus grands à se protéger.

Un avis d’une page publié par l’organisation expose brièvement cinq raisons pour lesquelles les parents ne devraient pas offrir ces jouets à leurs enfants.

Parmi ces raisons : les jouets d’IA reposent souvent sur les mêmes technologies qui ont déjà causé du tort aux enfants ; ils exploitent la confiance des plus jeunes ; perturbent la construction des relations et de la résilience ; portent atteinte à la vie privée en collectant des données sensibles ; et remplacent des activités essentielles au développement créatif et cognitif.

« Des tests réalisés par le Public Interest Research Group ont déjà révélé des jouets d’IA indiquant à des enfants où trouver des couteaux, leur apprenant à allumer une allumette, ou engageant des conversations à caractère sexuel », affirme Fairplay.

Les enfants ont tendance à croire ce que dit l’IA, tandis que celle-ci est préprogrammée pour les maintenir heureux et divertis, souligne l’organisation.

L’avis précise qu’après avoir recueilli des informations privées sur les familles et les enfants, « les fabricants peuvent utiliser ces données intimes pour rendre leurs systèmes plus réalistes, réactifs et addictifs, leur permettant d’établir une relation avec l’enfant et, finalement, de vendre des produits ou services ».

Quand un enfant joue avec une peluche classique, il mobilise son imagination et s’engage dans le jeu symbolique, essentiel à son développement.

« À l’inverse, les jouets d’IA dirigent les interactions via des scripts préchargés, des consignes et des réponses prévisibles, risquant ainsi d’étouffer ce développement », indique l’avis.

Les fabricants affirment que ces jouets ont une valeur éducative, mais celle-ci est minime : un enfant peut apprendre « quelques faits ou mots de vocabulaire », précise Fairplay.

Rachel Franz, directrice du programme Young Children Thrive Offline de Fairplay, a déclaré le 20 novembre :

« L’IA conversationnelle a déjà nui aux adolescents. Intégrer cette même technologie dans des jouets mignons et destinés aux enfants expose des enfants encore plus jeunes à des risques que nous ne comprenons pas encore entièrement. »

« Il est aberrant que ces jouets ne soient pas réglementés et qu’on les vende aux familles en promettant sécurité, apprentissage et amitié – des promesses sans fondement alors que de nombreuses preuves montrent que cette technologie peut causer de réels dommages. »

« Le risque est tout simplement trop grand. Les enfants doivent pouvoir jouer avec leurs jouets, et non être manipulés par eux. »

Le 11 septembre, la Federal Trade Commission (FTC) a annoncé l’ouverture d’une enquête sur les chatbots d’IA utilisés comme compagnons.

« Protéger les enfants en ligne est une priorité absolue pour la FTC [sous la présidence de Donald Trump et la vice-présidence de JD Vance], tout comme encourager l’innovation dans les secteurs clés de notre économie », a déclaré Andrew N. Ferguson, président de la FTC.

« L’étude que nous lançons aujourd’hui nous aidera à mieux comprendre comment les entreprises d’IA développent leurs produits et les mesures qu’elles prennent pour protéger les enfants. »

Jouets intégrant l’IA

L’avertissement de Fairplay intervient alors que les fabricants cherchent de plus en plus à intégrer l’IA dans leurs gammes. En juin, Mattel a par exemple annoncé une collaboration avec OpenAI pour développer des produits dotés d’IA.

Dans une déclaration d’octobre réaffirmant sa position, la Toy Association – qui représente plus de 900 entreprises américaines – soutient l’usage judicieux de l’IA et des jouets connectés.

« La sécurité des jouets est la priorité absolue de l’industrie, et protéger les enfants ainsi que maintenir la confiance des parents fait partie de cette mission », indique le communiqué.

« De fait, tous les jouets vendus aux États-Unis doivent respecter plus de 100 normes et tests afin de garantir la sécurité physique des enfants. »

« À mesure que l’Association suit l’évolution des nouvelles technologies, dont la croissance de l’IA, nous nous engageons à informer nos membres sur leurs applications possibles dans les jouets et sur la manière de garantir avant tout la sécurité des enfants et des familles. »

Un rapport du 13 novembre du Public Interest Research Group détaille les résultats de son évaluation de quatre jouets contenant des chatbots d’IA interagissant avec des enfants.

Le groupe a constaté que certains jouets abordaient des sujets inappropriés et donnaient des conseils dangereux.

Certaines entreprises de jouets ont mis en place des garde-fous pour s’assurer que les jouets dotés d’IA soient adaptés aux enfants, a indiqué le groupe, mais celui-ci a constaté que « l’efficacité de ces garde-fous varie et qu’ils peuvent parfois être totalement inefficaces ».

Keyi Technology, Mattel et OpenAI n’ont pas répondu aux demandes de commentaires.

Naveen Athrappully est un journaliste qui couvre l'actualité économique et internationale

Articles actuels de l’auteur